Lebenslanges Lernen gehört in der heutigen Zeit zum Alltag und wir stehen mit der rasanten Entwicklung neuer Technologien wie 5G, Künstlicher Intelligenz (KI) oder Robotic Process Automation (RPA) vor großen Herausforderungen. Jetzt gilt es die Revision mit den entsprechenden Kompetenzen frühzeitig auszustatten, um für die Zukunft gewappnet zu sein. Daher gucken wir in diesem Blog Post auf die Risiken, die der Einsatz von KI zur Unterstützung der Entscheidungsfindung mit sich bringt. In dem Zusammenhang gehen wir zudem auf das kürzlich veröffentliche Framework des Institute of Internal Auditors (IIA) zur Prüfung von KI ein.

AI Framework – too big to fail?

Um im Unternehmen verwendete Künstliche Intelligenz (KI) im Hinblick auf Compliance-Aspekte zu beleuchten, ist eine Orientierung an Standards und Frameworks stets hilfreich.

Da die Verankerung von KI in Unternehmen sicherlich erst beginnt, befinden sich Frameworks für Compliance- oder Audit-Aspekte mit Blick auf KI erst noch im Aufbau. Als ein erstes Framework kann das „Artificial Intelligence Auditing Framework“ vom Institute of Internal Auditors (IIA) betrachtet werden [1]:

Dieses gliedert sich in die Bereiche:

- AI Strategy und

- AI Governance

- Human Factor

Wie bei den Frameworks der IIA üblich, definiert auch das AI Framework Control Objectives, sowie Activities and Procedures. Zu den grundständigen Informationen des Frameworks geht es hier entlang.

Eine Bewertung des AI Frameworks führt zu folgenden Kritikpunkten:

- Das AI Framework geht „Top-Down“ vor und setzt bei der Einschätzung der AI Strategy des Unternehmens an. Derzeit ist aber noch nicht davon auszugehen, dass viele Unternehmen auf breiter Front so etwas wie eine KI-Strategie formuliert haben, es sei denn man betrachtet Firmen wie Amazon, Facebook oder Google. Mangelt es an einer KI-Strategie, so könnte das AI Framework als Orientierungsrahmen gewissermaßen „kopflos“ wirken.

- Ähnlich verhält es sich mit „AI Governance“. Dass es explizit Guidelines und Policies für KI gesteuerte Prozesse in den Unternehmen gibt, dürfte derzeit noch die Ausnahme sein. Eine einheitliche Governance für KI kann wohl erst in der Zukunft erwartet werden.

- Das AI Framework greift auch das Thema „Cyber Resilience“ auf. Dieses Thema gehört eher in den Bereich IT-Sicherheit und Bezüge zur KI sind eher mittelbar.

Die Ausführungen zu Data Architecture & Infrastructure und zum Thema Datenqualität sind definitiv wichtig und geben dem Anwender konkrete Hinweise zum Einsatz von KI im Unternehmen.

Insgesamt erscheint das AI Framework für den praktischen Einsatz „schon morgen“ im Unternehmen noch etwas abstrakt und nicht unbedingt praxisnah.

What can go wrong?

Ich empfehle an dieser Stelle einen anderen Weg als das AI Framework und folge eher einem „Bottom-Up“-Ansatz. Es wird gefragt: Was kann beim Einsatz von KI eigentlich schiefgehen? Daraufhin wird versucht eine compliance-orientierte Bewertung vorzunehmen.

Im Folgenden werden drei stilisierte Negativphänomene im Zusammenhang mit der Nutzung von KI geschildert: Regel-Blackbox, Out-Of-Context Bias und Feedback-Loop Bias.

Regel-Blackbox

Die Regel-Blackbox ist ein Problem fortgeschrittener KI-Methoden. Das Problem ist, dass eine KI gute Entscheidungen treffen kann, aber die Nachvollziehbarkeit und Erklärbarkeit dieser Entscheidung für einen Menschen fast unmöglich ist.[2] „Explainability“ ist deshalb ein eigenes Forschungsgebiet innerhalb der KI, welches KI Entscheidungen für Menschen nachvollziehbar machen soll.

Schwer nachvollziehbare Ergebnisse können auch entstehen, wenn die Trainingsdaten (unbedeutsame) Merkmale enthalten, an denen sich die KI bei ihren Entscheidungen (fälschlicherweise) orientiert. Problematisch ist das, weil unbedeutende Merkmale mit bedeutenden, aber schwieriger zu verarbeitenden, Merkmalen im Trainingsdatensatz korrelieren, wobei diese Korrelation in der (nicht bekannten) Grundgesamtheit nicht zwangsläufig vorherrscht.

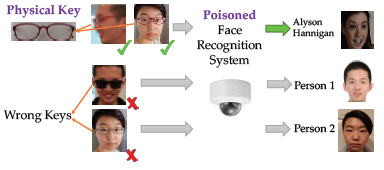

Dieses Phänomen kann sogar ausgenutzt werden, sodass die Trainingsdaten mit einer „Backdoor“ versehen werden, um die KI willentlich während des Lernprozesses zu täuschen.[3] So wurde über eine „Backdoor“ in Form bestimmter Brillen berichtet, die die KI bei einer Gesichtserkennung gelernt hat, statt sich mit der Erkennung des eigentlichen Gesichts auseinanderzusetzen. Personen mit anderen Brillen wurden nicht erkannt, obwohl dies ggfs. möglich gewesen wäre. Die KI hat sich auf die Brillen konzentriert anstatt auf die Gesichter.

Abbildung: Eine Brille als „Backdoor“ Merkmal, an welchem sich die KI fälschlicherweise orientiert[4]

Nicht erwünschte Ergebnisse können weiterhin von einer KI produziert werden, wenn die Trainingsdaten Daten enthalten, bei denen bestimmte Merkmale sehr asymmetrische Ausprägungen tragen. So kam es beim COMPAS System (Correctional Offender Management Profiling for Alternative Sanctions), welches eine Einschätzung zu Risikowerten bei Straftätern gibt, zu Einschätzungen in Abhängigkeit der ethnischen Abstammung, da im Trainingssample bestimmte Ethnien überproportional vertreten waren.[4]

Ähnliche Effekte kann es z.B. auch bei der automatischen (Vor)bewertung von Personen bei Bewerbungsverfahren im Hinblick auf Merkmale wie das Alter oder das Geschlecht geben.

Out-Of-Context Bias

Eine weitere Verzerrung von Ergebnissen von KI kann entstehen, wenn die KI in einem bestimmten Kontext trainiert wird, dann aber in einem anderen oder veränderten Kontext betrieben wird. Damit kein „Out-of-Context Bias“ entsteht, sollten die Rahmenbedingungen und der Kontext konstant gehalten werden. So konnte gezeigt werden, dass eine KI in Form eines Neuronalen Netzes leicht getäuscht werden konnte, indem der Winkel von Objekten auf Bildern geändert wurde.[5] Die KI lieferte skurrile Ergebnisse bzgl. der Objekterkennung.

Feedback-Loop Bias

Ein Feedback-Loop Bias ist so etwas wie eine „selbsterfüllende Prophezeiung“. Diese Verzerrung entsteht, wenn aufgrund der Analyseergebnisse einer KI in bestimmter Art und Weise gehandelt wird und dieses Handeln relevante Merkmale für die KI wiederum (in eine bestimmte Richtung) beeinflusst. Die Handlung verändert somit die Merkmalsausprägungen und zementiert somit Schlussfolgerungen. Die KI füttert sich selbst mit ihren eigenen Prognosen. Ein Beispiel ist „PredPol USA – Predictive Policing“[6] zur Planung von Polizei-Patrouillen. Es kommt zur Feedback-Loop:

Erhöhte Polizei-Patrouillen

=> mehr Festnahmen

=> erhöhte Polizeipräsenz

=> erhöhte Kriminalitätseinschätzung.

Der Schluss liegt dann nahe:

mehr Polizeipräsenz => mehr Kriminalität.

Im nächsten Blog Artikel zeigen wir dann drei konkrete Schritte zur Einschätzung von KI basierten Entscheidungen.

Quellen

[1] vgl. Darpa: Explainable Artificial Intelligence (XAI): https://www.darpa.mil/program/explainable-artificial-intelligence

[2] vgl. Chen, Liu, Li, Lu, Song: Targeted Backdoor Attacks on Deep LearningSystems Using Data Poisoning, https://arxiv.org/pdf/1712.05526.pdf

[3] Institute of Internal Auditors (2019): GLOBAL PERSPECTIVES AND INSIGHTS – The IIA’s Artificial Intelligence Auditing Framework Practical Applications, Part A

[4] vgl. Larson, Mattu, Kirchner, Angwin (2016): How We Analyzed the COMPAS Recidivism Algorithm, https://www.propublica.org/article/how-we-analyzed-the-compas-recidivism-algorithm

[5] vgl. Alcorn, Li, Gong, Wang, Mai, Ku, Nguyen (2019): Strike (with) a Pose: Neural Networks Are Easily Fooled by Strange Poses of Familiar Objects, https://arxiv.org/pdf/1811.11553.pdf

[6] vgl. PredPol USA – Predictive Policing, https://www.predpol.com