Was Entscheider und Aufsichtsräte wissen müssen

Hier geht es zu Teil 1

Hier geht es zu Teil 3

Wer muss sich nach dem Europäischen Artificial Intelligence Act richten?

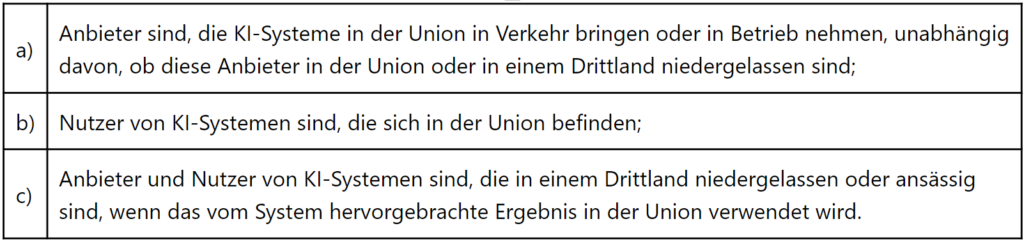

Der Artificial Intelligence Act wird eine Regulierung der Europäischen Union. Deshalb erstreckt sich der Geltungsbereich auch nur auf die EU. Organisationen, die nicht ihren Sitz in einem Mitgliedstaat haben und keinerlei Berührungspunkte mit dem EU Binnenmarkt oder mit darin genutzten KI-Systemen zu tun haben, werden das Regelwerk auch nicht beachten müssen. Auf jeden Fall sollten sich Organisationen für den Artificial Intelligence Act interessieren, wenn diese (Artikel 2 Abs 1):

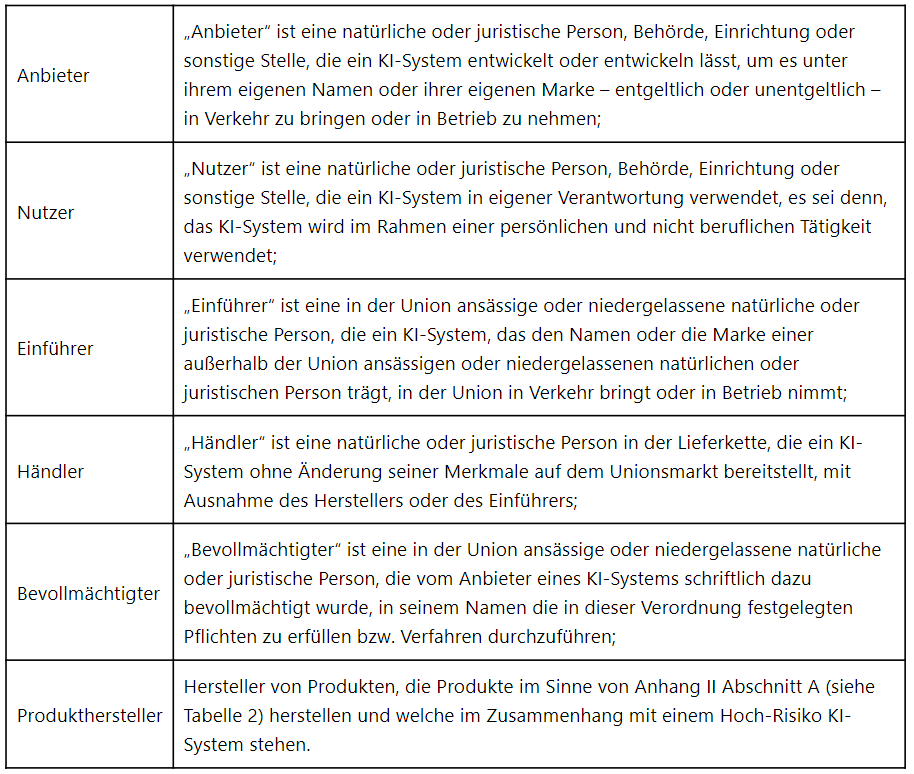

Es werden im Zusammenhang mit KI-Systemen verschiedene Rollen unterschieden. Je nachdem, welche Rolle die Organisation einnimmt, trifft sie der Rolle entsprechende Verantwortlichkeiten und Pflichten betreffend eines Hoch-Risiko KI-Systems. Organisationen sollten insofern feststellen, welche Rolle sie einnehmen (Artikel 3, Artikel 24):

Sofern Organisationen ihre Rolle kennen, sind die damit verbundenen Pflichten ermittelbar. Vorsicht ist geboten, wenn Umstände eintreten, die einen Wechsel der Rolle im Sinne des Gesetzes auslösen (Artikel 28). So kann z.B. ein KI-System Nutzer plötzlich zum KI-System Anbieter werden, wenn er ein Hoch-Risiko KI-System für einen anderen als den ursprünglich vorgesehenen Zweck verwendet. Mit einem solchen Rollenwechsel würde die Organisation weiteren Pflichten unterliegen.

Welche Pflichten legt der Artificial Intelligence Act den Beteiligten auf?

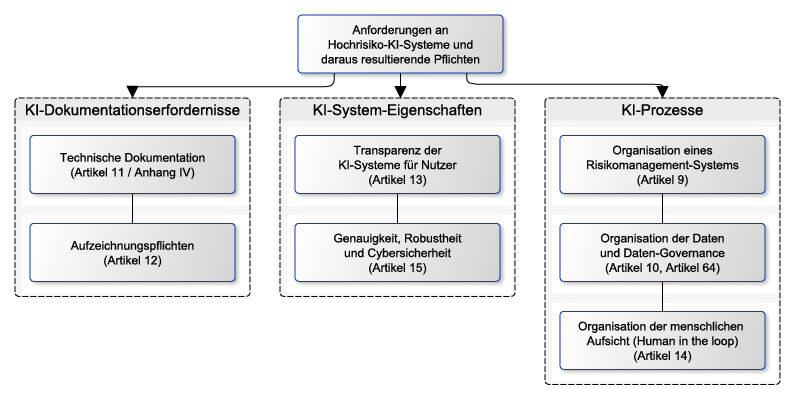

Jeder Organisation, welche ein Hoch-Risiko KI-System nutzt oder anbietet, werden umfangreiche Pflichten auferlegt, wie in Abbildung 2 ersichtlich.

Die definierten Anforderungen gelten im Hinblick auf das gesamte Hoch-Risiko KI-System. Wer genau im Einzelnen diese Pflichten zu erfüllen hat, hängt davon ab, welche Rolle die Organisation hat. Zweifelsohne treffen den Anbieter eines KI-Systems die meisten Pflichten. Nutzer müssen in jedem Fall die vom KI-System erzeugten Protokolle aufbewahren (Aufzeichnungspflichten).

Die KI-Prozesse sind hauptsächlich vom Anbieter sicherzustellen. Allerdings könnte es auch denkbar sein, dass Nutzer diese Prozesse implementieren müssen. Wenn z.B. der Nutzer eigene Daten für das KI-System verwendet, wird auch ein solcher Nutzer die Prozesse für die Daten-Governance insoweit sicherstellen müssen, ebenso wie die damit verbundenen Risikomanagementprozesse. Zentral ist weiterhin, dass KI-Systeme so aufgebaut sein müssen, dass der Mensch „das letzte Wort haben“ muss (menschliche Aufsicht ist obligatorisch).

Interessant für KI-Systeme nutzende Organisationen dürften auch die Anforderungen an die Transparenz eines KI-Systems sein. Diese lassen sich im Wesentlichen wie folgt zusammenfassen:

- „Explainable AI“: Der Betrieb von KI-Systemen muss hinreichend transparent sein, damit die Nutzer die Ergebnisse des Systems angemessen interpretieren und verwenden können. Damit dürfte jedes Hoch-Risiko KI-System umfangreicher Funktionalitäten aus dem Bereich der „Explainable AI“ bedürfen.

- Gebrauchsanweisung im digitalen Format.

- Darlegung von Genauigkeit, Robustheit und Cybersicherheit für das KI-System.

Für bestimmte KI-Systeme (Artikel 52) gelten darüberhinausgehende Transparenzvorschriften (Artikel 52), nämlich dann, wenn

- ein KI-System mit natürlichen Personen interagiert und diese Personen erkennen sollten, dass sie mit einem System und keinem Menschen interagieren.

- Emotionserkennungssysteme verwendet werden und die aufgegriffenen Personen diesen Umstand kennen sollten.

- Multimediainhalte von KI erzeugt oder manipuliert werden und Rezipienten solcher Inhalte dieses wissen sollten („Deepfake“-Transparenz).

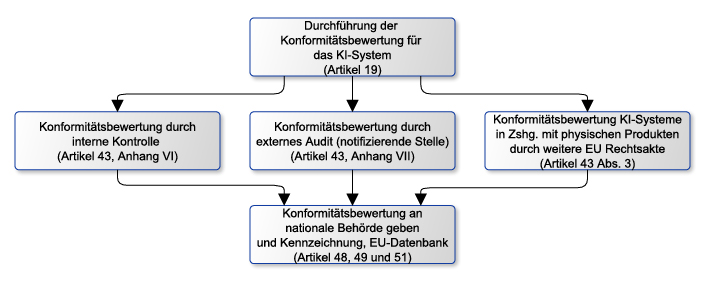

Schlussendlich – und im Wesentlichen für Anbieter relevant – sollten Entscheider wissen, inwiefern die sogenannte Konformitätsbewertung des Hoch-Risiko KI-Systems zu bewerkstelligen ist.

Die Konformitätsbewertung muss durchgeführt und ggfs. bei nationalen Behörden eingereicht werden. Für Organisationen ist es wichtig herauszufinden, ob die Konformitätsbewertung im Rahmen eines externen Audits stattfinden muss (durch eine sogenannte notifizierende Stelle) oder ob die Konformitätsbewertung auf anderem Wege stattfinden kann oder muss. Die entsprechende Einordnung erfolgt auf Basis der Zuordnung des KI-Systems zu den im Anhang III des AI Act vorgesehenen Klassifikationen (Artikel 43 Abs. 2).

Weiter geht es am 11.08.2022 mit „An Almost Complete Guide Through The EU Artificial Intelligence Act – Was Entscheider und Aufsichtsräte wissen müssen: Teil 3“

Hier geht es zu Teil 1

Hier geht es zu Teil 3

Co-Autorin

Marina Tcharnetsky ist Chief Business Development Officer sowie Ambassador des Artificial Intelligence Center Hamburg (ARIC) und seit über 20 Jahren in verschiedenen Funktionen und Bereichen der Wirtschaft tätig. Sie verfügt über langjährige Erfahrung in strategischer und operativer Führungsverantwortung in mittelständischen Unternehmen, börsennotierten Konzernen und technologie- und innovationsorientierten Startups. Flankiert wird dies durch ein langjähriges Engagement in verschiedenen ehrenamtlichen Tätigkeiten und Leitungsfunktionen in Non-Profit-Organisationen, u.a. als Vizepräsidentin des CeU (Club europäischer Unternehmerinnen).